Schnell war vielen klar, das der Pinguin im letzten Jahr für den hohen Verlust der Sichtbarkeit in den Google Suchergebnissen verantwortlich war. Allerdings gab es kurz zuvor auch ein Panda-Update, das für erhebliche Rankingverluste sorgte. War es also wirklich der Pinguin oder optimiert man jetzt an der falschen Stelle?

Schnell war vielen klar, das der Pinguin im letzten Jahr für den hohen Verlust der Sichtbarkeit in den Google Suchergebnissen verantwortlich war. Allerdings gab es kurz zuvor auch ein Panda-Update, das für erhebliche Rankingverluste sorgte. War es also wirklich der Pinguin oder optimiert man jetzt an der falschen Stelle?

Nur wenige Webseiten haben nach Penguin 1.0 im letzten Jahr ihre alten Positionen wieder erreicht. Die meisten fristen auch nach Überarbeitung des gesamten Linkportfolios und neuer Backlinks immer noch ein Nischendasein. So war es auch mit einigen meiner Projekte, weshalb ich mir diese einmal genauer angesehen habe. Zuvor möchte ich aber noch kurz auf die beiden Updates eingehen, die die SERPs kräftig durcheinander gewürfelt haben.

Das Pinguin-Update

Bei diesem Update handelt es sich um eine Algorithmus-Änderung, die sich um den Offpage-Bereich gekümmert hat. Googles Hauptziel waren alle Seiten und Projekte, die sich über zahlreiche Backlinks und entsprechende Ankertexte eine der vorderen Positionen in den Suchergebnissen erarbeitet haben. Hat man während des Linkaufbaus zu sehr auf Keywords in den Ankertexten geachtet, dann musste man schmerzliche Verluste hinnehmen. Ebenso verhielt es sich bei den Backlinks, die in Googles Augen künftig keinen Wert mehr haben sollten. Dazu zählten diejenigen Links, die man selber setzen konnte, ohne das es eine Prüfung der jeweiligen Seitenbetreiber gab. Wer also alles auf eine Karte gesetzt hat und viele Links in den zahlreich vorhandenen Bookmark-Diensten, Artikelverzeichnissen, Bloglisten usw. gesetzt hat, der hat dies am 24. April 2012 deutlich zu spüren bekommen.

Das Panda-Update

Hier handelt es sich ebenfalls um eine Algorithmus-Änderung, die allerdings schon vor Penguin in der ersten Version ausgerollt wurde. Mittlerweile gab es schon das 25. Panda Update. Backlinks spielen hierbei vermutlich nur eine sehr geringe bis gar keine Rolle. Dafür wurde der Content und die interne Verlinkung einer Webseite unter die Lupe genommen. Was in welcher Gewichtung von Google für die neuen SERPs genutzt wurde, kann niemand genau sagen. Einen großen, wenn nicht sogar den größten, Anteil nimmt dabei der reine Content in Anspruch. Hier spricht man von so genanntem Thin-Content. Im Klartext heißt das, das man im Vergleich zur restlichen Seite zu wenig Inhalte präsentiert. Wer also nur kurze Texte geschrieben und diese in viel Werbung eingebettet hat, dürfte zu den größten Verlierern gehören. Aber nicht nur die Textlänge ist entscheidend, sondern auch die Inhalte. Ich wage jetzt mal zu bezweifeln, das Google wirklich einen hervorragenden Artikel erkennen kann. Was aber durchaus mit technischen Hilfsmittel zu messen ist, ist die Formatierung des Contents. Wurde hier ein kleiner Fließtext geschrieben, der den Eindruck vermittelt, das man sich keine große Mühe gegeben und kaum bis gar nicht recherchiert hat? Hat man mit Absätzen, Zwischenüberschriften, Hervorhebungen und Bilder gearbeitet? Bei entsprechender Formatierung ist der Text für den Nutzer erheblich besser lesbar und das wirkt sich sowohl direkt als auch indirekt auf den Panda aus.

- Direkte Auswirkung auf den Panda

- Indirekte Auswirkung auf den Panda

Die genutzten Elemente wie Fettdruck, Überschriften, Aufzählungen, Links und Bilder sind direkt messbar und geben Google das Signal eines gut recherchierten Artikels, der für den Besucher und nicht für die Suchmaschine geschrieben wurde.

Auch der Besucher merkt, das ein Text gut lesbar geschrieben wurde. Er findet schneller die relevanten Passagen und liest den Artikel komplett, anstatt vorzeitig abzubrechen. Das erhöht die Verweildauer, die wiederum ein Indiz für den Panda ist, das die Besucher eine Seite interessant finden.

Wer war jetzt für den Rankingverlust verantwortlich?

Nachdem bei einigen meiner Projekte auch der Aufbau guter Backlinks kaum Wirkung zeigten und die Webseite teilweise sogar noch weiter abgerutscht ist, habe ich mir alles noch ein wenig genauer angesehen. Ist das Projekt sehr umfangreich, dann kann es eine wahre Sissifus-Arbeit sein, hier zu urteilen, ob es wohl an den Links oder an den Inhalten gelegen hat. Erst vor kurzem ist mir eine sehr interessante Webseite untergekommen, bei der ich direkt ablesen konnte, ob eine meiner Seite durch die 3 Pinguin oder die 25 Panda Updates in Mitleidenschaft gezogen wurde.

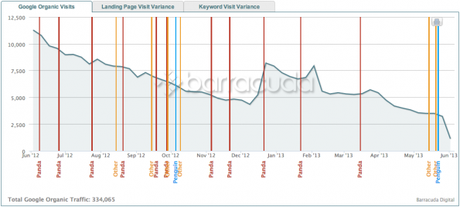

Als erstes ruft man dazu die folgende Webseite. auf. Passend zum Panda und Pinguin gab man ihm den Namen Panguin Tool. Im nächsten Schritt loggt man sich in seinen Analytics Account ein und gibt dem Tool das temporäre Recht, die Auswertungen einzusehen. Schon wird eine aussagekräftige Grafik erstellt, die aus nichts weiter als den Google Zugriffen der eingegebenen Periode und den überlagernden Updates von Penguin, Panda und Co bestehen. Jetzt lässt sich sehr deutlich erkennen, ob vor einem Rankingverlust ein Penguin oder Panda Update stand. Gerade im letzten Jahr muss man etwas genauer hinsehen und evtl. auch auf tägliche Werte umstellen. Bei einem meiner Projekte konnte ich dadurch erkennen, das der Absturz bereits einige Tage vor Penguin erfolgte und daher Panda verantwortlich war. Hier nützt ein Backlinkaufbau nicht viel, da auch Seiten mit guter Backlinkstruktur kaum wieder auf vordere Positionen gelangen, wenn man sich nicht gleichzeitig um den Content kümmert.

So entkommt man dem Panda (Panda Recovery)

Eigentlich ist es gar nicht so schwer, eine Seite, die durch Panda abgestürzt ist, wieder nach vorne zu bringen. Allerdings geht das nicht von heute auf morgen. Im ersten Schritt sorgt man dafür, das das Verhältnis von Content zum Rest der Webseite erhöht wird. Bei einem Blogsystem wie WordPress ist das schnell erledigt. Hier und da eine Werbung entfernen und die interne Verlinkung entschlacken. Schwieriger wird es bei den Inhalten, bzw. den Artikeln. Bestehen diese nur aus Thin-Content oder haben keine bis wenige Formatierungen, dann muss man Hand anlegen und tippen. Je nach Umfang des Blogs kann das eine Menge Zeit in Anspruch nehmen. Es macht durchaus auch Sinn, alte zu kurze Artikel zu löschen oder in einem einzigen Artikel zusammenzufassen. Auf diese Weise haben nach meiner Recherche verschiedene Blogs wieder die alten Positionen erreicht. Jedoch muss man sich hier auf einen längeren Zeitraum einstellen, da zum einen die Änderungen nicht über Nacht gemacht sind und zum anderen Google die Seiten erst neu crawlen und bewerten muss. Geduld ist also auch ein wichtiger Faktor, um dem Panda zu entkommen.

Foto: © simonemascetti – Fotolia.com