Laut einer Analyse des US-amerikanischen Unternehmens für Internetsicherheit Incapsula gehen nur 44 Prozent des Website-Traffics direkt von Menschen aus, die übrigen 56 Prozent von Bots.

Mehr Statistiken finden Sie bei Statista

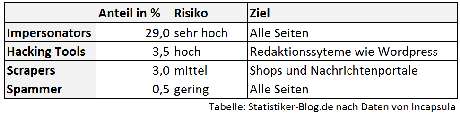

Davon sind rund die Hälfe, also 27 Prozent des gesamten Traffics, unschädlich. Das können beispielsweise Webcrawler von Suchmaschinenbetreibern sein. Doch immerhin 29 Prozent sind potentiell gefährlich. Besonders häufig sind sogenannte Impersonater. Das englische Wort lässt sich am besten mit Darsteller oder Imitator übersetzen, diese Bots werden beispielsweise bei DDoS-Attacken eingesetzt, bei denen Seiten mit massenhaften Anfragen überschüttet und so blockiert werden. Mitunter sollen sie auch Nutzer ausspähen. Diese Bots machen alleine 22 Prozent des gesamten Traffics aus - vor zwei Jahren waren es noch 19 Prozent.

Hacking-Tools sind für 3,5 Prozent des Traffic verantwortlich, sie versuchen Daten zu stehlen oder schädliche Software zu installieren. Klauen wollen auch die Scraper (3,0 Prozent), die entweder Inhalte von Websites stehlen oder E-Mail-Adressen einsammeln. Spammer kommen erstaunlicherweise nur auf 0,5 Prozent des Traffic, obwohl Kommentar-Spam schon lange eine echte Plage ist - oder besser wäre, wenn das Plugin Akismet nicht ziemlich elegant das meiste davon rausschmeißen würde. Spaßeshalber lasse sich mal ein paar Spam-Kommentar durch, nur um zu zeigen, wie schlecht die sind. Natürlich ohne Links um die Spammer nicht zu belohnen.

Grafik verwenden? Bitte mit Link zu Statistiker-Blog.de.

Betroffen sind vor allem kleine Seiten, denn bei wenigen Nutzern fallen ein paar Bots natürlich besonders stark ins Gewicht. Bei weniger als 1.000 Besuchern am Tag sind durchschnittlich 80 Prozent des Traffic durch Bots verursacht, aber selbst große Angebote mit mehr als einer Millionen Besuchern am Tag haben einen Bot-Anteil von über 50 Prozent.

Natürlich stellt sich jetzt die Frage: Wie aussagekräftig sind diese Daten? Immerhin ist das Erheben von Daten im Internet nicht ganz einfach, wie auch die von Quelle zu Quelle schwankenden Zahlen zur Nutzung von Browsern zeigen.

Immerhin hat man sich bei Incapsula Mühe gegeben und nach eigenen Angaben 90 Tage lang 20.000 Seiten beobachtet. Bedingung für die Aufnahme waren mindestens zehn menschliche Besucher am Tag und der Schutz der Seiten durch Incapsula. Um Bots und menschliche Nutzer zu unterscheiden wurden verschiedene Verfahren verwendet, beispielsweise wurde das Verhalten der Besucher beobachtet und die IP-Adresse analysiert. Somit bleibt natürliche eine leichte Unschärfe. Allerdings habe ich wenig Zweifel, dass die Größenordnungen stimmen, auch wenn das keine schöne Erkenntnis ist. Also Augen auf beim Surfen!